Broj oblasti u kojima se eksperimentiše sa različitim dostignućima veštačke inteligencije je značajan, a nivo investicija u ovaj segment ogroman i u konstantnom porastu, pa ne treba da nas iznenadi mišljenje dela javnosti da je možda na pomolu nova tehnološka revolucija.

U trenutku svog predstavljanja – utisak je autora ovog teksta – ChatGPT izazvao je šok u IT industriji i široj populaciji. Istraživači u oblasti veštačke inteligencije eksperimentisali su sa velikim jezičkim modelima (LLMs – large language models) nekoliko godina do tog trenutka, ali šira javnost nije obraćala pažnju na ovaj razvoj i nije shvatala koje mogućnosti ovi modeli poseduju. Danas je kompletna IT industrija svesna postojanja velikih jezičkih modela, a desetine miliona ljudi su ih isprobali. Bez obzira na to, utisak je da manjina zaista razume kako oni rade, koji su resursi korišćeni za njihov razvoj, koliko njih je dostupno besplatno i koje su potencijalne oblasti primene.

Jezik je jedinstvena sposobnost ljudskih bića. Iako ljudima relativno jednostavna, mašinama je sposobnost razumevanja ljudskog jezika izuzetno složen zadatak. Kao odgovor, istraživači su se decenijama unazad bavili modelovanjem jezika. Kreirani modeli su se inkrementalno kretali od statističkih jezičkih modela do neuronskih jezičkih modela. Iz istraživačkog rada generisani su pristupi koje danas imamo prilike da koristimo kroz aplikacije veštačke inteligencije koje se oslanjaju na svega dva zadatka – generisanje verovatnoće pojave sekvence tokena i generisanje verovatnoće pojave sledećeg i/ili nedostajućeg tokena (zarad ovog članka, tokenom možemo smatrati deo reči). Poslednja generacija jezičkih modela, nazvana transformer modelima, demonstrirala je velike mogućnosti u domenu rešavanja tradicionalnih problema obrade prirodnog jezika i nudi iskorak koji fascinira javnost. Transformer modeli, zasnovani na dubokim neuronskim mrežama i trenirani na ogromnim korpusima tekstova, pokazali su da je skaliranjem veličine modela moguće postići dodatne sposobnosti modela koje prethodno nisu bile dostupne, poput učenja u kontekstu.

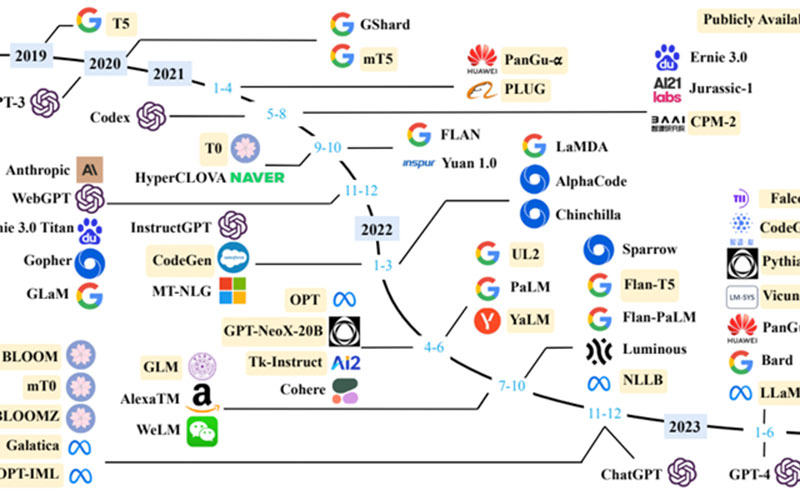

Ovakva i slična otkrića, uz tehnološki napredak, pokrenula su akademsku zajednicu i kompanije u smeru kreiranja novih i naprednijih transformer modela. Finansijski resursi uloženi u svaki ozbiljan korak ovog razvoja mere se milionima dolara, ljudsko angažovanje je konstantno u porastu, pa ne čudi činjenica da se novi modeli i njihove primene pojavljuju na mesečnom nivou. Rezultat je ekosistem mogućnosti, čiju ćemo evoluciju sagledati kako bi zagrebali po površini razumevanja onoga što većina ljudske populacije danas poistovećuje sa veštačkom inteligencijom – velikih jezičkih modela.

Izvori znanja: korpusi tekstova

Znajući zadatke za koje su modeli projektovani, nije teško pretpostaviti da je osnovni resurs za treniranje velikih jezičkih modela – tekst. S obzirom da je veličina modela u konstantnom porastu (trenutno modeli poseduju više stotina milijardi parametara), za trening modela koriste se heterogeni i uglavnom javno dostupni korpusi tekstova. U idealnom slučaju, potrebno je koristiti što veći korpus što kvalitetnijih tekstova. BookCorpus je skup podataka koji je u prethodnom periodu često korišćen za trening modela. Sastoji se od preko 11.000 knjiga, koje pokrivaju širok spektar tema i žanrova. Još jedan sličan i značajan korpus velikih razmera je Project Gutenberg, koji se sastoji od preko 70.000 književnih izdanja (romani, eseji, poezija, drama, istorija, nauka…). Project Gutenberg je jedna od najvećih javno dostupnih kolekcija knjiga i koristi se u treningu modela MT-NLG i LLaMA.

CommonCrawl je kolekcija tekstova čija se veličina meri u petabajtima. Ova kolekcija nastala je indeksiranjem i obradom sadržaja dostupnih na internetu i verovatno je najšire korišćen skup tekstova za trening različitih jezičkih modela. S obzirom da predstavlja rezultat prikupljanja sadržaja sa interneta, CommonCrawl sadrži tekstove lošijeg kvaliteta, pa su razvojni timovi često pribegavali procesiranju tekstova pre treninga i izdvajanju podskupa tekstova iz CommonCrawl skupa koji odgovaraju specifičnoj nameni. Takvim postupkom kreirani su skupovi tekstova C4, CCStories, CC-News i RealNews, koji se često koriste za trening modela.

OpenWebText je javno dostupna kopija WebText skupa, koji je korišćen za treniranje GPT-2 modela i trenutno sadrži preko 10 miliona HTML stranica. PushShift je skup podataka generisan sa platforme Reddit, ažurira se u realnom vremenu i sadrži podatke datirane od trenutka pokretanja Reddit platforme. Wikipedia je onlajn enciklopedija koja sadrži veliki broj visokokvalitetnih članaka, pokrivajući širok spektar tema, jezika i oblasti. Filtrirane verzije tekstova Wikipedije na engleskom jeziku koriste se za trening većine velikih jezičkih modela (GPT-3, LaMDA, LLaMA).

Razvojni timovi najčešće koriste mešavinu tekstova u inicijalnoj fazi treninga jezičkih modela. U praksi, ovaj proces obuhvata odabir tekstova i procesiranje tekstova kako bi se kreirali skupovi koji su pripremljeni za specifičan model. Neki od javno dostupnih modela koristili su sledeće skupove tekstova u inicijalnoj fazi treninga modela:

- GPT-3 (175 milijardi parametara) treniran je na mešovitom skupu podataka od 300 milijardi tokena, uključujući CommonCrawl, WebText2, Books1, Books2 i Wikipediju.

- PaLM (540 milijardi parametara) koristi skup podataka od 780 milijardi tokena, koji se dobijaju iz konverzacija na društvenim mrežama, filtriranjem sadržaja web stranica, knjiga, Githuba, Wikipedije.

- Llama izdvaja trening skup iz različitih izvora, uključujući CommonCrawl, C4, Github, Wikipediju, knjige, ArXiv i StackExchange. Veličina podataka za obuku Llama modela sa 7 milijardi parametara i modela sa 13 milijardi parametara je 1 bilion tokena, dok je 1,4 biliona tokena korišćeno za Llama modele sa 32 i 65 milijardi parametara.

Osnovni resurs za treniranje velikih jezičkih modela je tekst, u idealnom slučaju što veći korpus što kvalitetnijih tekstova

Evolucija GPT modela

Generative Pre-trained Transformer – GPT jedan je od najkorišćenijih modela i ujedno model koji je korišćen za razvoj ChatGPT sistema, koji je snažno uticao na akademsku zajednicu i industriju. Osnovni zadaci definisani pri kreiranju modela su izuzetno ambiciozni: ugradnja sveg znanja dostupnog na internetu u model i kreiranje modela koji je u stanju da, na osnovu ugrađenog znanja, rešava opšte zadatke. U svrhe rešavanja zadataka, postojeća arhitektura transformer modela izmenjena je i izvršeno je skaliranje duboke neuronske mreže, čiji se broj parametara danas meri stotinama milijardi.

- GPT-1 – Nakon objave transformer modela 2017. godine od strane kompanije Google, OpenAI tim je prilagodio svoje istraživanje novoj arhitekturi. Nakon prilagođavanja arhitekture kreiran je naziv Generative Pre-trained Transformer – GPT za arhitekturu koja poseduje samo dekoderski deo transformer modela i čiji je osnovni zadatak predikcija narednog tokena. Na ovim principima razvijen je i predstavljen GPT-1 model.

- GPT-2 – Arhitektura modela skalirana je na korišćenje 1,5 milijardi parametara, dok je model treniran na značajno većem skupu neoznačenih tekstova. Autori su se usmerili ka nenadgledanom treningu, koristeći premisu da je svaki zadatak postavljen pred model moguće rešiti predikcijom narednog tokena, posmatrajući odgovarajući podskup svih ikada napisanih tekstova. U ovoj fazi razvoja, GPT-2 je još uvek zaostajao u kvalitetu rezultata za najboljim modelima čiji je trening baziran na nadgledanom učenju.

- GPT-3 – Model je predstavljen 2020. godine i poseduje 175 milijardi parametara. Razvojni tim po prvi put uvodi proces učenja u kontekstu, što dozvoljava modelu da razume zadatke opisane prirodnim jezikom. Sposobnosti modela su značajno unapređene, čime je skaliranje modela u potpunosti opravdano. Iz tog razloga, ova generacija modela smatra se prvim pravim predstavnikom velikih jezičkih modela kakve danas koristimo.

- GPT-4 – Model sa izuzetnim poboljšanjima predstavljen je u martu 2023. godine. GPT-4 bezbednije odgovara na zlonamerne ili provokativne upite, zbog šestomesečnog iterativnog finog treniranja baziranog na ljudskoj podršci. Dodatno, razvojni tim prikazao je nove mehanizme nazvane red teaming i predictable scaling, koji se koriste za uklanjanje mogućnosti generisanja neprikladnog sadržaja i u svrhe predikcije performansi modela.

Veliki jezički modeli svoju snagu temelje na ljudskom znanju, a njihova osnovna prednost je sveobuhvatnost znanja koje se stiče kroz tekstove na kojima su trenirani

Veliki jezički modeli kao kopiloti naše svakodnevice

Veliki jezički modeli svoju snagu temelje na ljudskom znanju. Njihova osnovna prednost je sveobuhvatnost znanja koje se stiče kroz tekstove na kojima su trenirani. Utisak koji se može steći u pojedinim situacijama je da su ovakvi modeli „sveznajući“, pa tako imaju potencijal da budu upotrebljeni kao domenski eksperti. Javnost je trenutno bila zaintrigirana mogućnostima u oblastima zdravstva,

obrazovanja, prava, finansija i naučnog istraživanja.

Zdravstvena zaštita je jedna od prvih oblasti u kojima su mogućnosti modela ispitivane. Pokazalo se da su modeli sposobni da se bave raznim zadacima ove oblasti, poput medicinske konsultacije ili pojednostavljenja medicinskih izveštaja. Većina modela je specijalno trenirana za oblast zdravstvene zaštite i time su njihove performanse u oblasti unapređene. Na primer, Med-PaLM modeli su postigli rezultate koji su uporedivi sa rezultatima stručnjaka na ispitima za licence medicinskih radnika u SAD. I pored toga, stručna javnost upozorava da, zbog svoje arhitekture, modeli još uvek mogu pogrešno protumačiti medicinske termine ili dati savete koji nisu u skladu sa medicinskom praksom.

U oblasti prava akademska zajednica je predstavila niz rezultata u primeni modela za rešavanje različitih zadataka, poput analize pravnih dokumenata, predikcije presuda i generisanja pravnih dokumenata. Poslednja verzija GPT-4 modela postigla je rezultat koji je u najboljih 10% rezultata pravnog ispita advokata u SAD u poređenju sa realnim kandidatima. Dalji progres modela u oblasti prava očekuje se sa razvojem posebnih modela koji bi bili u stanju da kontekstno zaključuju. U oblasti legislative Republike Srbije, na sajtu HuggingFace, dostupan je model SrBERTa, koji je moguće koristiti za analizu pravnih dokumenata s područja Republike Srbije. Uprkos napretku koji je nedvosmislen, stručna javnost izražava bojazan od potencijalne pristrasnosti ili diskriminacije lica od strane ovakvih modela.

Utisak je da su finansije oblast u kojoj veliki jezički modeli tek treba da dokažu svoju upotrebljivost. Trenutno, generalni modeli imaju lošije performanse u odnosu na jezičke modeli kreirane specifično za finansijski domen. BloombergGPT je pokazao izvanredne performanse u različitim finansijskim zadacima, pri čemu je ostao konkurentan i u opštim zadacima.

Obrazovanje je, takođe, važan domen primene u kome veliki jezički modeli potencijalno imaju značajan uticaj. Empirijske studije akademske zajednice pokazale su da veliki jezički modeli mogu biti odlični asistenti prilikom kreiranja nastavnog materijala. Nedavne studije istražuju različita scenarija primene velikih jezičkih modela u nastavi u učionici, kao što su kolaboracija nastavnika i učenika, personalizovano učenje i automatizacija ocenjivanja. Međutim, primena velikih jezičkih modela u obrazovanju može dovesti do niza praktičnih problema, poput plagijarizma, potencijalne nepreciznosti u sadržaju koji generiše model, preteranog oslanjanja i poverenja u informacije generisane od strane velikog jezičkog modela i umanjene dostupnosti za pojedince koji ne govore engleski jezik.

U pojedinim situacijama deluje kao da su veliki jezički modeli „sveznajući“, s potencijalom da budu upotrebljeni kao domenski eksperti

Jesu li naša očekivanja prevelika?

Broj oblasti u kojima se eksperimentiše sa različitim dostignućima veštačke inteligencije je značajan: analiza i generisanje slika, transformacija prirodnog jezika u slike, cybersecurity, chatbots, poslovna analitika, procesiranje prirodnog jezika, generisanje izvornog koda softverskih aplikacija, primena modela veštačke inteligencije u robotici… Imajući sve oblasti u vidu, veliki jezički modeli su samo deo dijapazona mogućnosti koji polako postaje dostupan čovečanstvu. Nivo investicija u ovu oblast je ogroman i u konstantnom je porastu, pa naša očekivanja prosto prate ovaj trend. Sveukupno posmatrano, ne treba da nas iznenadi mišljenje jednog dela javnosti da je možda na pomolu nova tehnološka revolucija. Svaki značajan tehnološki napredak prati bojazan od potencijalne maliciozne upotrebe inovacija, pa u narednom periodu, osim daljeg progresa ove oblasti, možemo očekivati analizu uticaja ove tehnologije na svakodnevicu i odgovor čovečanstva u pogledu prilagođavanja i legislative.

Miloš Bogdanović, COMING

0 %s Comments